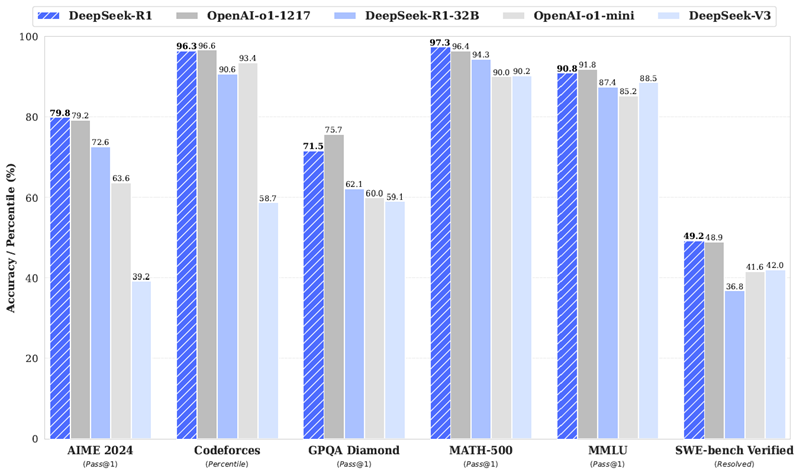

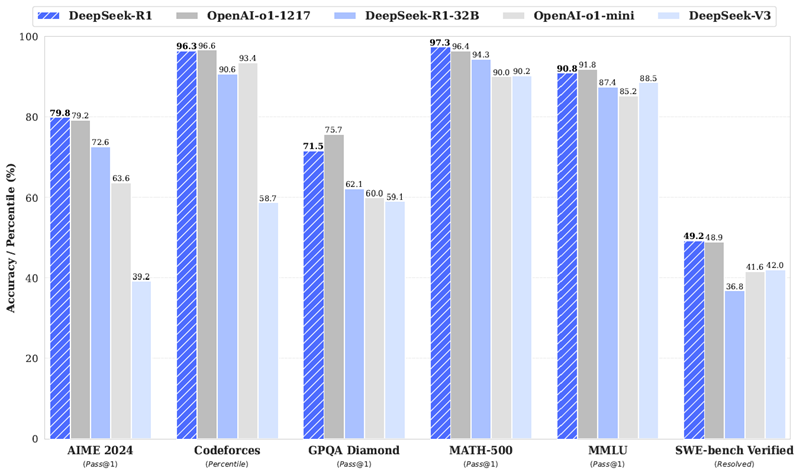

第一世代の推論モデルであるDeepSeek-R1-ZeroとDeepSeek-R1を紹介します。DeepSeek-R1-Zeroは、教師あり微調整(SFT)を前段階として用いず、大規模強化学習(RL)によって学習されたモデルであり、優れた推論能力を発揮します。DeepSeek-R1-Zeroは、RLを通して、多くの強力で興味深い推論動作を自然に獲得します。しかし、可読性の低さや言語の混在といった課題に直面しています。これらの問題を解決し、推論性能をさらに向上させるために、RLの前に多段階学習とコールドスタートデータを組み込んだDeepSeek-R1を紹介します。DeepSeek-R1は、推論タスクにおいてOpenAI-o1-1217に匹敵する性能を達成しています。研究コミュニティをサポートするために、DeepSeek-R1-Zero、DeepSeek-R1、およびQwenとLlamaに基づいてDeepSeek-R1から蒸留された6つの高密度モデル(1.5B、7B、8B、14B、32B、70B)をオープンソース化しています。

近年、大規模言語モデル(LLM)は急速な反復と進化を遂げており(Anthropic、2024年、Google、2024年、OpenAI、2024a)、汎用人工知能(AGI)とのギャップは徐々に縮小しています。

最近、事後学習は学習パイプライン全体の重要な要素として浮上しています。 事後学習は、推論タスクの精度を向上させ、社会的価値観と整合させ、ユーザーの嗜好に適応することが示されていますが、事前学習と比較して比較的少ない計算リソースで済みます。推論能力の観点では、OpenAIのo1 (OpenAI, 2024b) シリーズモデルは、Chain-of-Thought 推論プロセスの長さを増やすことで推論時間のスケーリングを導入した最初のモデルです。このアプローチは、数学、コーディング、科学的推論など、様々な推論タスクにおいて大幅な改善を実現しました。しかし、効果的なテスト時間のスケーリングという課題は、研究コミュニティにとって未解決のままです。先行研究では、プロセスベース報酬モデル(Lightman et al., 2023; Uesato et al., 2022; Wang et al., 2023)、強化学習(Kumar et al., 2024)、モンテカルロ木探索やビーム探索などの探索アルゴリズム(Feng et al., 2024; Trinh et al., 2024; Xin et al., 2024)など、様々なアプローチが検討されてきました。しかし、これらの手法のいずれも、OpenAIのo1シリーズモデルに匹敵する汎用推論性能を達成していません。

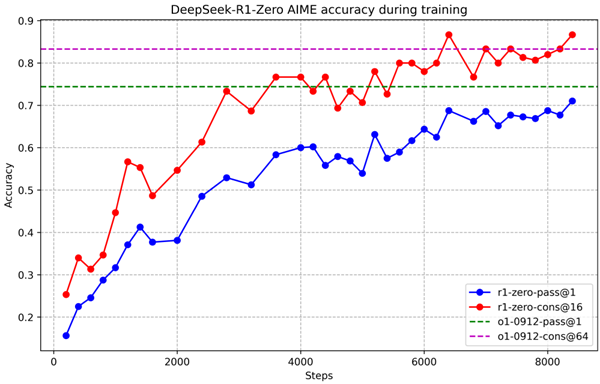

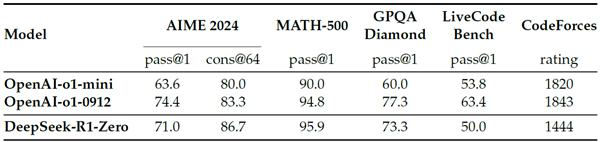

本稿では、純粋強化学習(RL)を用いて言語モデルの推論能力向上に向けた第一歩を踏み出します。目標は、教師データなしでLLMが推論能力を開発する可能性を探り、純粋RLプロセスによる自己進化に焦点を当てることです。具体的には、DeepSeek-V3-Baseをベースモデルとして用い、GRPO(Shao et al., 2024)をRLフレームワークとして採用することで、推論におけるモデル性能を向上させます。 トレーニング中、DeepSeek-R1-Zeroは、数多くの強力で興味深い推論動作を自然に発現しました。数千回のRLステップを経て、DeepSeek-R1-Zeroは推論ベンチマークで優れた性能を発揮します。例えば、AIME 2024のpass@1スコアは15.6%から71.0%に向上し、多数決投票を適用するとスコアはさらに86.7%に向上し、OpenAI-o1-0912の性能に匹敵します。

しかし、DeepSeek-R1-Zeroは、可読性の低さや言語の混在といった課題に直面しています。これらの問題に対処し、推論性能をさらに向上させるために、少量のコールドスタートデータと多段階のトレーニングパイプラインを組み込んだDeepSeek-R1を導入します。具体的には、まず数千のコールドスタートデータを収集し、DeepSeek-V3-Baseモデルを微調整します。その後、DeepSeek-R1-Zeroと同様に推論指向の強化学習を実行します。強化学習プロセスの収束に近づくと、強化学習チェックポイントで拒否サンプリングを行い、新しいSFTデータを作成します。このデータと、ライティング、事実に基づく品質保証、自己認識などの領域におけるDeepSeek-V3の教師ありデータを組み合わせて、DeepSeek-V3-Baseモデルを再学習します。新しいデータで微調整した後、チェックポイントは、すべてのシナリオからのプロンプトを考慮した追加の強化学習プロセスにかけられます。これらの手順を経て、DeepSeek-R1と呼ばれるチェックポイントを取得しました。これはOpenAI-o1-1217と同等のパフォーマンスを達成しました。

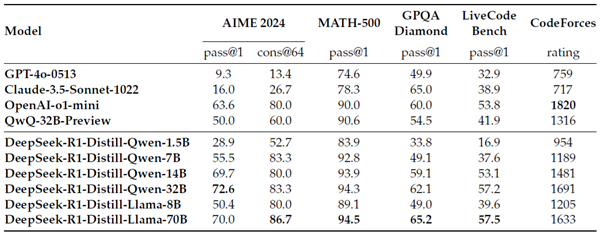

DeepSeek-R1からより小規模な密モデルへの蒸留についてさらに調査しました。Qwen2.5-32B (Qwen, 2024b) をベースモデルとして用いた場合、DeepSeek-R1からの直接蒸留は、これに強化学習を適用した場合よりも優れた性能を示しました。これは、より大規模なベースモデルによって発見された推論パターンが推論能力の向上に不可欠であることを示しています。蒸留したQwenおよびLlama (Dubey et al., 2024) シリーズをオープンソース化しました。特に、蒸留した14Bモデルは最先端のオープンソースQwQ-32B-Preview (Qwen, 2024a) を大幅に上回り、蒸留した32Bおよび70Bモデルは密モデルの中で推論ベンチマークの新記録を樹立しました。

学習後:ベースモデルにおける大規模強化学習

蒸留:小規模モデルも強力になり得る

これまでの研究では、モデルの性能向上のために大量の教師ありデータに大きく依存してきました。本研究では、コールドスタートとして教師あり微調整(SFT)を用いなくても、大規模な強化学習(RL)によって推論能力を大幅に向上できることを実証します。さらに、少量のコールドスタートデータを加えることで、性能をさらに向上させることができます。以下のセクションでは、(1) SFTデータなしでベースモデルに直接強化学習を適用するDeepSeek-R1-Zero、および(2) 数千の長い思考連鎖(CoT)例で微調整されたチェックポイントから強化学習を適用するDeepSeek-R1を紹介します。3) DeepSeek-R1の推論能力を小規模な密なモデルに蒸留します。

強化学習は、これまでの研究(Shao et al., 2024; Wang et al., 2023)で実証されているように、推論タスクにおいて大きな有効性を示しています。しかしながら、これらの研究は教師ありデータに大きく依存しており、その収集には膨大な時間がかかります。本セクションでは、教師ありデータなしでLLMが推論能力を開発する可能性を探り、純粋な強化学習プロセスによる自己進化に焦点を当てます。まず、私たちの強化学習アルゴリズムの概要を簡単に説明し、その後、いくつかの興味深い結果を紹介します。これがコミュニティに貴重な洞察を提供することを願っています。

グループ相対ポリシー最適化

強化学習の学習コストを削減するため、グループ相対ポリシー最適化 (GRPO) (Shao et al., 2024) を採用します。GRPO では、通常ポリシーモデルと同じサイズの批評モデルを使用せず、代わりにグループスコアからベースラインを推定します。具体的には、各質問 \(𝑞\) に対して、GRPO は古いポリシー \(𝜋_{𝜃_{𝑜𝑙𝑑}}\) から出力のグループ \(\{𝑜_1, 𝑜_2, · · · , 𝑜_𝐺\}\) をサンプリングし、次の目的関数を最大化することでポリシーモデル \(𝜋_𝜃\) を最適化します。

\[

\begin{align}

&\mathcal J_{GRPO}(\theta) =\mathbb E[q\sim P(Q),\{o_i\}_{i=0}^G\sim \pi_{\theta_{old}}(O|q)] \\

\\

&\frac{1}{G}\sum_{i=1}^G

\Big(\min\Big(\frac{\pi_\theta(o_i|q)}{\pi_{\theta_{old}}(o_i|q)}A_i,clip

\Big(\frac{\pi_\theta(o_i|q)}{\pi_{\theta_{old}}(o_i|q)}

,1-\varepsilon,1+\varepsilon\Big)

A_i\Big)-\beta\mathbb D_{KL}(\pi_\theta||\pi_{ref})\Big)

\tag{1} \\

\\

&\mathbb D_{KL}(\pi_\theta||\pi_{ref})=\frac{\pi_{ref}(o_i|q)}{\pi_\theta(o_i|q)}-\log\frac{\pi_{ref}(o_i|q)}{\pi_\theta(o_i|q)}-1

\tag{2}

\end{align}

\]

ここで、\(𝜀\) と \(𝛽\) はハイパーパラメータであり、\(𝐴_𝑖\) は各グループ内の出力に対応する報酬のグループ \(\{𝑟_1, 𝑟_2, . . . , 𝑟_𝐺\}\) を使用して計算される利点です。

\[

A_i=\frac{r_i-mean(\{r_1,r_2,.\cdots,r_G\})}{std(\{r_1,r_2,\cdots,r_G\})}

\tag{3}

\]

報酬は学習信号の源であり、RL の最適化方向を決定します。 DeepSeek-R1-Zero を学習するために、主に 2 種類の報酬で構成されるルールベースの報酬システムを採用しています。

DeepSeek-R1-Zeroの開発では、結果型またはプロセス型のニューラル報酬モデルは適用していません。これは、ニューラル報酬モデルが大規模な強化学習プロセスにおいて報酬ハッキングの影響を受ける可能性があること、また、報酬モデルの再学習には追加の学習リソースが必要となり、学習パイプライン全体が複雑化する可能性があるためです。

DeepSeek-R1-Zero を学習するために、まずベースモデルが指定した指示に従うように導く、わかりやすいテンプレートを設計します。表 1 に示すように、このテンプレートでは、DeepSeek-R1-Zero がまず推論プロセスを生成し、次に最終的な答えを生成する必要があります。私たちは意図的にこの構造形式に制約を限定し、コンテンツ固有のバイアス(例えば、反射的推論の強制や特定の問題解決戦略の促進など)を避けています。これにより、強化学習プロセス中のモデルの自然な進化を正確に観察できるようになります。

ユーザーとアシスタント間の会話。ユーザーが質問し、アシスタントがそれを解決します。 アシスタントはまず頭の中で推論プロセスを考え、それからユーザーに答えを提供します。推論プロセスと答えはそれぞれ <think> </think> タグと <answer> </answer> タグで囲まれます。つまり、<think> 推論プロセスはここに </think>, <answer> 答えはここに </answer> となります。ユーザー:プロンプト。アシスタント:

表1 | DeepSeek-R1-Zeroのテンプレート。プロンプトは、トレーニング中に具体的な推論質問に置き換えられます。

DeepSeek-R1-Zero のパフォーマンス

図2は、AIME 2024ベンチマークにおけるDeepSeek-R1-Zeroのパフォーマンスの軌跡を、RL学習プロセス全体を通して示しています。図に示すように、DeepSeek-R1-Zeroは、RL学習が進むにつれて着実かつ一貫したパフォーマンス向上を示しています。特に、AIME 2024における平均pass@1スコアは大幅に向上し、当初の15.6%から驚異的な71.0%へと飛躍的に向上し、OpenAI-o1-0912に匹敵するパフォーマンスレベルに達しています。この大幅な改善は、当社のRLアルゴリズムがモデルのパフォーマンスを時間の経過とともに最適化する有効性を浮き彫りにしています。

図2 | 学習中のDeepSeek-R1-ZeroのAIME精度。各質問に対して16件の回答をサンプリングし、全体の平均精度を計算することで、安定した評価を確保しています。

表2は、様々な推論関連ベンチマークにおけるDeepSeek-R1-ZeroとOpenAI o1-0912モデルの比較分析を示しています。この結果から、RLによって強化されることが明らかになっています。

表2 | 推論関連ベンチマークにおけるDeepSeek-R1-ZeroとOpenAI o1モデルの比較。

DeepSeek-R1-Zeroは、教師あり微調整データなしで堅牢な推論能力を獲得しました。これは注目すべき成果であり、RLのみで効果的に学習および一般化できるモデルの能力を強調しています。さらに、DeepSeek-R1-Zeroの性能は、多数決を適用することでさらに向上します。例えば、AIMEベンチマークで多数決を適用すると、DeepSeek-R1-Zeroの性能は71.0%から86.7%に向上し、OpenAI-o1-0912の性能を上回ります。多数決の有無にかかわらず、DeepSeek-R1-Zeroがこれほど競争力のある性能を達成できることは、その強力な基礎能力と、推論タスクにおけるさらなる進歩の可能性を浮き彫りにしています。

DeepSeek-R1-Zero の自己進化プロセス

DeepSeek-R1-Zero の自己進化プロセスは、強化学習がモデルの推論能力を自律的に向上させる様子を示す興味深い例です。ベースモデルから直接強化学習を開始することで、教師あり微調整段階の影響を受けずに、モデルの進化を綿密に監視できます。このアプローチにより、モデルが時間の経過とともにどのように進化するか、特に複雑な推論タスクを処理する能力に関して、明確な可視化が可能になります。

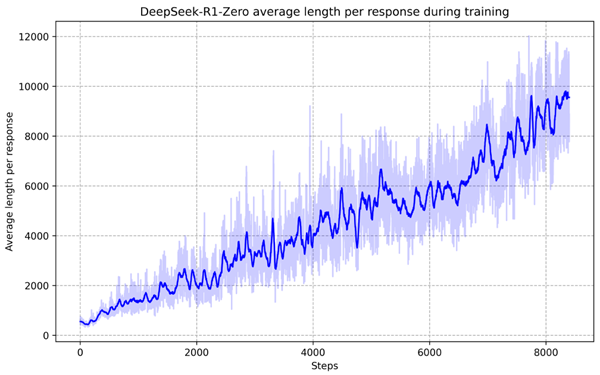

図3に示すように、DeepSeek-R1-Zeroの思考時間は学習プロセス全体を通して着実に改善しています。この改善は外部調整によるものではなく、モデル内部の本質的な進化によるものです。DeepSeek-R1-Zeroは、テスト時間の延長計算を活用することで、ますます複雑な推論タスクを解く能力を自然に獲得します。この計算は数百から数千の推論トークンを生成することから始まり、モデルが思考プロセスをより深く探求し、洗練させることを可能にします。

図3 | 強化学習プロセス中のトレーニングセットにおけるDeepSeek-R1-Zeroの平均応答長。DeepSeek-R1-Zeroは、より多くの思考時間で推論タスクを解くことを自然に学習します。

この自己進化の最も注目すべき点の一つは、テスト時の計算が増加するにつれて、洗練された動作が出現することです。モデルが以前のステップを再訪して再評価するリフレクションや、問題解決のための代替アプローチの探索といった動作は、自発的に発生します。これらの動作は明示的にプログラムされているわけではなく、モデルと強化学習環境との相互作用の結果として出現します。この自発的な発達により、DeepSeek-R1-Zeroの推論能力が大幅に向上し、より困難なタスクにもより高い効率と精度で取り組むことができるようになります。

DeepSeek-R1-Zero のアハ体験

DeepSeek-R1-Zero の学習中に観察された特に興味深い現象は、「アハ体験」の発生です。表3 に示すように、この瞬間はモデルの中間バージョンで発生します。このフェーズでは、DeepSeek-R1-Zero は初期のアプローチを再評価することで、問題により多くの思考時間を割り当てることを学習します。この動作は、モデルの推論能力の向上を証明するだけでなく、強化学習が予期せぬ高度な結果をもたらす可能性があることを示す魅力的な例でもあります。

この瞬間は、モデルにとってだけでなく、その行動を観察する研究者にとっても「アハ体験」となります。これは強化学習の力と美しさを際立たせるものです。モデルに問題の解決方法を明示的に教えるのではなく、適切なインセンティブを与えるだけで、モデルは自律的に高度な問題解決戦略を開発します。この「アハ体験」は、強化学習が人工システムの知能を新たなレベルに引き上げる可能性を強く示唆し、将来、より自律的で適応性の高いモデルへの道を開くでしょう。

質問: 𝑎 > 1 の場合、\(\sqrt{a-\sqrt{a+x}}=x\) の実数解の和は?

応答: <think>

方程式 \(\sqrt{a-\sqrt{a+x}}= 𝑥\) を解くには、まず両方の平方根を二乗することから始めましょう。

\(\left(\sqrt{a-\sqrt{a+x}}\right)^2=x^2\implies a-\sqrt{a+x}=x^2\)

内側の平方根項を分離するように変形します。

\((𝑎 − 𝑥^2)^2 = 𝑎 + 𝑥 \implies 𝑎^2 − 2𝑎𝑥^2 + (𝑥^2)^2 = 𝑎 + 𝑥 \implies 𝑥^4 − 2𝑎𝑥^2 - 𝑥 + (𝑎^2 − 𝑎) = 0\)

\(\cdots\)

ちょっと待って。ちょっと待って。これは「なるほど!」という瞬間だ。

正しい和が · · · になるかどうか、段階的に再評価してみましょう。

まず、次の式から始めました。

\(\sqrt{a-\sqrt{a+x}}=x\)

まず、両辺を2乗してみましょう。

\(𝑎 −\sqrt{a+x}=x^2 \implies \sqrt{a+x}=a-x^2\)

次に、両辺をもう一度2乗して、次の式を扱います。· · ·

· · ·

表3 | DeepSeek-R1-Zeroの中級バージョンにおける興味深い「アハ体験」。モデルは擬人化された口調で考え直すことを学習します。これは私たちにとっても「アハ体験」であり、強化学習の力と美しさを目の当たりにする機会となりました。

DeepSeek-R1-Zero の欠点

DeepSeek-R1-Zero は強力な推論能力を示し、予期せぬ強力な推論行動を自律的に構築しますが、いくつかの課題に直面しています。例えば、DeepSeek-R1-Zero は可読性の低さや言語の混在といった課題を抱えています。推論プロセスの可読性を高め、オープンコミュニティと共有するために、人間が理解しやすいコールドスタートデータを用いた強化学習(RL)を利用する手法である DeepSeek-R1 を検討します。

DeepSeek-R1-Zero の有望な結果に触発され、2つの自然な疑問が浮かび上がります。1) 少量の高品質データをコールドスタートとして組み込むことで、推論性能をさらに向上させたり、収束を加速したりできるでしょうか? 2) 明確で一貫性のある思考の連鎖 (CoT) を生成するだけでなく、強力な汎用能力を発揮する、ユーザーフレンドリーなモデルをどのように学習できるでしょうか? これらの疑問を解決するために、DeepSeek-R1 を学習するためのパイプラインを設計します。このパイプラインは、以下に概説する4つのステージで構成されています。

DeepSeek-R1-Zeroとは異なり、ベースモデルからの強化学習トレーニングの初期段階における不安定なコールドスタートを防ぐため、DeepSeek-R1では少量の長いCoTデータを構築・収集し、モデルを初期強化学習アクターとして微調整します。このようなデータを収集するために、私たちはいくつかのアプローチを検討しました。長いCoTを例として、少数のショットのプロンプトを使用する、モデルに直接プロンプトを出して熟考と検証を伴う詳細な回答を生成する、DeepSeek-R1-Zeroの出力を読み取り可能な形式で収集する、そして人間の注釈者による後処理によって結果を改良する、といったアプローチです。

本研究では、DeepSeek-V3-BaseをRLの出発点として微調整するために、数千のコールドスタートデータを収集します。DeepSeek-R1-Zeroと比較したコールドスタートデータの利点は次のとおりです。

DeepSeek-V3-Baseをコールドスタートデータで微調整した後、DeepSeek-R1-Zeroで採用されているものと同じ大規模強化学習トレーニングプロセスを適用します。このフェーズでは、特にコーディング、数学、科学、論理推論といった、明確に定義された問題と明確な解決策を伴う推論集約型タスクにおいて、モデルの推論能力を強化することに重点を置いています。トレーニングプロセス中、特に強化学習プロンプトに複数の言語が含まれる場合、CoTが言語の混合を示すことが観察されました。言語の混合の問題を軽減するために、強化学習トレーニング中に言語の一貫性報酬を導入します。これは、CoTにおけるターゲット言語の単語の割合として計算されます。アブレーション実験では、このような調整によってモデルのパフォーマンスがわずかに低下することが示されていますが、この報酬は人間の好みと一致し、より読みやすくなります。最後に、推論タスクの精度と言語一貫性の報酬を直接加算して最終的な報酬を算出します。その後、微調整されたモデルに強化学習を適用し、推論タスクで収束するまで学習を継続します。

推論指向強化学習が収束すると、得られたチェックポイントを利用して、次のラウンドのためのSFT(教師あり微調整)データを収集します。主に推論に焦点を当てた初期のコールドスタートデータとは異なり、この段階では、ライティング、ロールプレイング、その他の汎用タスクにおけるモデルの能力を強化するために、他のドメインからのデータを組み込みます。具体的には、以下のようにデータを生成し、モデルを微調整します。

推論データ

上記の強化学習トレーニングのチェックポイントから拒否サンプリングを行うことで、推論プロンプトをキュレートし、推論軌跡を生成します。前の段階では、ルールベースの報酬を使用して評価できるデータのみを含めていました。しかし、この段階では、追加データを取り込んでデータセットを拡張します。その一部は、生成報酬モデルを使用して、グラウンドトゥルース値とモデル予測をDeepSeek-V3に入力して判断を行います。

さらに、モデルの出力は時に混乱を招き、読みにくくなるため、言語の混在、長い言い換え、コードブロックなどによる思考の連鎖を除外しました。各プロンプトに対して複数の回答をサンプリングし、正解のみを保持します。合計で、推論関連のトレーニングサンプルを約60万件収集します。

非推論データ

文章作成、事実に基づくQA、自己認識、翻訳といった非推論データについては、DeepSeek-V3パイプラインを採用し、DeepSeek-V3のSFTデータセットの一部を再利用します。特定の非推論タスクでは、プロンプトで質問に答える前に、DeepSeek-V3を呼び出して潜在的な思考の連鎖を生成します。ただし、「こんにちは」などの単純なクエリについては、CoTは提供しません。最終的に、推論とは無関係なトレーニングサンプルを合計約20万個収集しました。

上記のキュレーション済みデータセット(約80万サンプル)を用いて、DeepSeek-V3-Baseを2エポックにわたって微調整します。

モデルを人間の嗜好にさらに適合させるため、モデルの有用性と無害性を向上させると同時に推論能力を洗練させることを目的とした二次強化学習段階を実装します。具体的には、報酬信号と多様なプロンプト分布を組み合わせてモデルを学習します。推論データについては、DeepSeek-R1-Zeroで概説されている方法論に従います。この方法は、ルールベースの報酬を用いて数学、コード、論理的推論の領域における学習プロセスを導きます。一般データについては、複雑で微妙なシナリオにおける人間の嗜好を捉えるために報酬モデルを使用します。DeepSeek-V3パイプラインを基盤とし、同様の嗜好ペアと学習プロンプトの分布を採用します。有用性については、最終的な要約のみに焦点を当て、評価においてユーザーへの応答の有用性と関連性を重視しつつ、基盤となる推論プロセスへの干渉を最小限に抑えます。無害性については、推論プロセスと要約の両方を含むモデルの応答全体を評価することで、生成プロセス中に発生する可能性のある潜在的なリスク、バイアス、または有害なコンテンツを特定し、軽減します。最終的には、報酬シグナルと多様なデータ分布を統合することで、有用性と無害性を優先しながら推論に優れたモデルを学習できるようになります。

DeepSeek-R1のような推論能力をより効率的な小規模モデルに搭載するため、DeepSeek-R1でキュレーションされた80万サンプルを用いて、Qwen (Qwen, 2024b)やLlama (AI@Meta, 2024)などのオープンソースモデルを直接微調整しました(§2.3.3参照)。その結果、この単純な蒸留手法によって、小規模モデルの推論能力が大幅に向上することが示されました。ここで使用したベースモデルは、Qwen2.5-Math-1.5B、Qwen2.5-Math-7B、Qwen2.5-14B、Qwen2.5-32B、Llama-3.1-8B、およびLlama-3.3-70B-Instructです。Llama-3.3を選択したのは、その推論能力がLlama-3.1よりもわずかに優れているためです。

蒸留モデルでは、強化学習(RL)を組み込むことでモデルのパフォーマンスを大幅に向上させることができるにもかかわらず、SFTのみを適用し、強化学習(RL)段階は含めません。ここでの主な目的は、蒸留手法の有効性を実証することであり、強化学習段階の検討はより広範な研究コミュニティに委ねます。

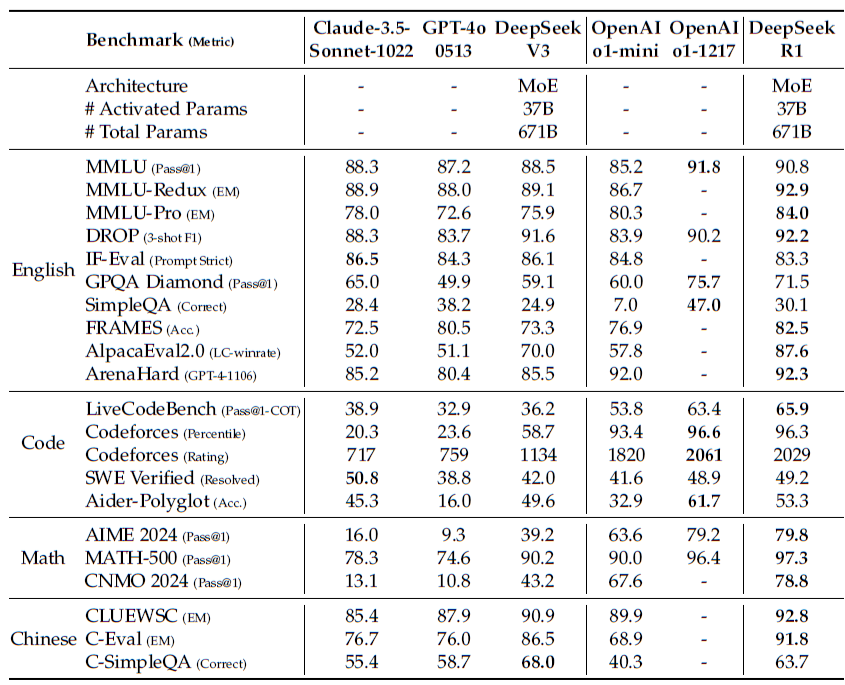

ベンチマーク:MMLU (Hendrycks et al., 2020)、MMLU-Redux (Gema et al., 2024)、MMLU-Pro (Wang et al., 2024)、C-Eval (Huang et al., 2023)、CMMLU (Li et al., 2023)、IFEval (Zhou et al., 2023)、FRAMES (Krishna et al., 2024)、GPQA Diamond (Rein et al., 2023)、SimpleQA (OpenAI, 2024c)、C-SimpleQA (He et al., 2024)、SWE-Bench Verified (OpenAI, 2024d)、Aider 1、LiveCodeBench (Jain et al., 2024) を用いてモデルを評価しました。 (2024-08 – 2025-01)、Codeforces 2、中国全国高校数学オリンピック (CNMO 2024)3、およびアメリカ招待数学試験2024 (AIME 2024) (MAA, 2024) で評価されています。標準ベンチマークに加えて、LLMを審査員として用いたオープンエンド生成タスクでもモデルを評価します。具体的には、GPT-4-Turbo-1106を一対比較の審査員として利用するAlpacaEval 2.0 (Dubois et al., 2024) とArena-Hard (Li et al., 2024) のオリジナル設定に準拠しています。ここでは、長さのバイアスを回避するため、最終要約のみを評価に使用しています。蒸留モデルについては、AIME 2024、MATH-500、GPQA Diamond、Codeforces、LiveCodeBench における代表的な結果を報告します。

1 https://aider.chat

2 https://codeforces.com

3 https://www.cms.org.cn/Home/comp/comp/cid/12.html

評価プロンプト

DeepSeek-V3のセットアップに従い、MMLU、DROP、GPQA Diamond、SimpleQAなどの標準ベンチマークは、simpleevalsフレームワークのプロンプトを使用して評価されます。MMLU-Reduxでは、ゼロショット設定でZero-Evalプロンプト形式(Lin, 2024)を採用しています。MMLU-Pro、C-Eval、CLUE-WSCについては、元のプロンプトがfew-shotであるため、ゼロショット設定に合わせてプロンプトをわずかに変更しています。few-shotのCoTはDeepSeek-R1のパフォーマンスに悪影響を与える可能性があります。他のデータセットは、作成者が提供するデフォルトのプロンプトを使用して、元の評価プロトコルに従います。コードと数学のベンチマークについては、HumanEval-Mulデータセットが8つの主要なプログラミング言語(Python、Java、C++、C#、JavaScript、TypeScript、PHP、Bash)をカバーしています。 LiveCodeBenchにおけるモデルのパフォーマンスは、2024年8月から2025年1月の間に収集されたデータを用いてCoT形式で評価されます。Codeforcesデータセットは、10のDiv.2コンテストの問題と専門家が作成したテストケースを用いて評価され、その後、競技者の予想レーティングと割合が算出されます。SWE-Benchで検証された結果は、エージェントレスフレームワーク(Xia et al., 2024)を介して取得されます。AIDER関連のベンチマークは「diff」形式で測定されます。DeepSeek-R1の出力は、各ベンチマークで最大32,768トークンに制限されます。

ベースライン

DeepSeek-V3、Claude-Sonnet-3.5-1022、GPT-4o-0513、OpenAI-o1-mini、OpenAI-o1-1217など、複数の強力なベースラインに対して包括的な評価を実施します。

中国本土ではOpenAI-o1-1217 APIへのアクセスが困難なため、公式レポートに基づいてパフォーマンスを報告します。蒸留モデルについては、オープンソースモデルであるQwQ-32B-Preview (Qwen, 2024a) とも比較します。

評価設定

モデルの最大生成長を32,768トークンに設定しました。

長出力推論モデルの評価に貪欲デコードを使用すると、繰り返し率が高くなり、チェックポイント間で大きなばらつきが生じることがわかりました。そのため、デフォルトでpass@𝑘評価 (Chen et al., 2021) を使用し、温度を0以外の値に設定してpass@1を報告します。

具体的には、サンプリング温度0.6、トップ𝑝値0.95を用いて、各質問に対して𝑘回答(テストセットのサイズに応じて、通常は4~64)を生成します。Pass@1は次のように計算されます。

\[

pass@1=\frac{1}{k}\sum_{i=1}^k p_i

\]

ここで、\(𝑝_𝑖\) は \(𝑖\) 番目の回答の正しさを表します。この手法は、より信頼性の高いパフォーマンス推定値を提供します。AIME 2024 については、64 サンプルを使用したコンセンサス(多数決)結果 (Wang et al., 2022) も報告しており、cons@64 と表記しています。

MMLU、MMLU-Pro、GPQA Diamond などの教育指向の知識ベンチマークにおいて、DeepSeek-R1 は DeepSeek-V3 と比較して優れたパフォーマンスを示しています。この改善は主に、大規模強化学習によって大幅な向上が達成された STEM 関連の問題における精度の向上によるものです。さらに、DeepSeek-R1は、長時間のコンテキスト依存QAタスクであるFRAMESにおいて優れた性能を示し、その強力なドキュメント分析能力を実証しています。これは、AI駆動型検索およびデータ分析タスクにおける推論モデルの潜在能力を浮き彫りにしています。事実に基づくベンチマークであるSimpleQAでは、DeepSeek-R1はDeepSeek-V3を上回り、事実に基づくクエリの処理能力を実証しています。同様の傾向が見られ、OpenAI-o1はこのベンチマークでGPT-4oを上回っています。しかし、DeepSeek-R1は、中国のSimpleQAベンチマークではDeepSeek-V3よりもパフォーマンスが低く、これは主に安全強化学習(Safety RL)後に特定のクエリへの回答を拒否する傾向があるためです。安全強化学習(Safety RL)がない場合、DeepSeek-R1は70%を超える精度を達成できます。

DeepSeek-R1は、モデルのフォーマット指示に従う能力を評価するために設計されたベンチマークであるIF-Evalでも印象的な結果を示しています。これらの改善は、教師あり微調整(SFT)と強化学習(RL)のトレーニングの最終段階で指示に従うデータを組み込んだことに起因しています。さらに、AlpacaEval2.0とArenaHardでも顕著なパフォーマンスが見られ、DeepSeek-R1がライティングタスクとオープンドメインの質問応答において強みを発揮していることを示しています。DeepSeek-V3を大幅に上回るパフォーマンスは、大規模RLの一般化の利点を強調しており、推論能力を高めるだけでなく、多様なドメインにわたるパフォーマンスも向上させます。さらに、DeepSeek-R1によって生成される要約の長さは簡潔で、ArenaHardでは平均689トークン、AlpacaEval 2.0では平均2,218文字です。これは、DeepSeek-R1がGPTベースの評価において長さのバイアスを回避し、複数のタスクにわたる堅牢性をさらに強化していることを示しています。

数学タスクにおいて、DeepSeek-R1はOpenAI-o1-1217と同等のパフォーマンスを示し、他のモデルを大きく上回っています。LiveCodeBenchやCodeforcesなどのコーディングアルゴリズムタスクでも同様の傾向が見られ、これらのベンチマークでは推論重視のモデルが優勢を占めています。エンジニアリング指向のコーディングタスクにおいて、OpenAI-o1-1217はAiderではDeepSeek-R1を上回りますが、SWE Verifiedでは同等のパフォーマンスを達成しています。関連するRLトレーニングデータの量は現在非常に限られているため、DeepSeek-R1のエンジニアリングパフォーマンスは次期バージョンで向上すると考えています。

表5に示すように、DeepSeek-R1の出力を単純に蒸留することで、効率的なDeepSeek-R1-7B(DeepSeek-R1-Distill-Qwen-7B、以下同様に略記)は、GPT-4o-0513などの非推論モデルを全面的に上回る性能を発揮します。DeepSeek-R1-14Bはすべての評価指標でQwQ-32BPreviewを上回り、DeepSeek-R1-32BとDeepSeek-R1-70Bはほとんどのベンチマークでo1-miniを大幅に上回ります。これらの結果は、蒸留モデルの大きな可能性を示しています。さらに、これらの蒸留モデルに強化学習を適用すると、大幅な性能向上が得られることがわかりました。これについてはさらなる検討が必要であると考え、ここでは単純なSFT蒸留モデルの結果のみを示します。

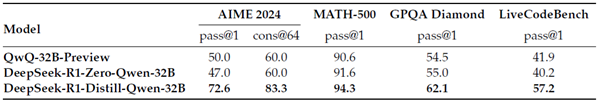

セクション3.2では、DeepSeek-R1を蒸留することで、小規模モデルでも優れた結果を達成できることがわかりました。しかし、まだ1つの疑問が残っています。論文で議論されている大規模RL学習において、蒸留を行わずに同等のパフォーマンスを達成できるのでしょうか?

この疑問に答えるために、数学、コード、STEMデータを用いてQwen-32B-Baseで大規模なRL学習を実施し、1万ステップ以上の学習を経てDeepSeek-R1-Zero-Qwen-32Bを作成しました。表6に示す実験結果は、32Bベースモデルが大規模RL学習後、QwQ-32B-Previewと同等の性能を達成することを示しています。しかし、DeepSeek-R1から蒸留されたDeepSeek-R1-Distill-Qwen-32Bは、すべてのベンチマークにおいてDeepSeek-R1-Zero-Qwen-32Bよりも大幅に優れた性能を示しました。

したがって、2つの結論を導き出すことができます。第一に、より強力なモデルをより小さなモデルに蒸留することで優れた結果が得られます。一方、本論文で述べた大規模強化学習に依存する小規模モデルは膨大な計算能力を必要とし、蒸留の性能にさえ達しない可能性があります。第二に、蒸留戦略は経済的かつ効果的ですが、知能の限界を超えるには、より強力なベースモデルとより大規模な強化学習が必要になる可能性があります。

DeepSeek-R1の開発初期段階では、途中で失敗や挫折にも遭遇しました。ここで失敗体験を共有するのは、洞察を提供するためですが、これらのアプローチが効果的な推論モデルを開発できないことを意味するものではありません。

プロセス報酬モデル(PRM)

PRMは、モデルを推論タスクの解決に向けたより良いアプローチへと導く合理的な手法です(Lightman et al., 2023; Uesato et al., 2022; Wang et al., 2023)。しかし、実際には、PRMには最終的な成功を妨げる可能性のある3つの主な制限があります。

第一に、一般的な推論における細粒度のステップを明示的に定義することは困難です。第二に、現在の中間ステップが正しいかどうかを判断することは困難なタスクです。モデルを使用した自動アノテーションでは満足のいく結果が得られない可能性があり、手動アノテーションはスケールアップに適していません。第三に、モデルベースのPRMを導入すると、必然的に報酬ハッキング(Gao et al., 2022)につながり、報酬モデルの再学習には追加の学習リソースが必要になり、学習パイプライン全体が複雑になります。結論として、PRMはモデルによって生成された上位N個の回答を再ランク付けしたり、誘導探索を支援したりする優れた能力を示していますが(Snell et al., 2024)、その利点は、私たちの実験における大規模強化学習プロセス中に導入される追加の計算オーバーヘッドと比較すると限られています。

モンテカルロ木探索(MCTS)

AlphaGo(Silver et al., 2017b)とAlphaZero(Silver et al., 2017a)に着想を得て、モンテカルロ木探索(MCTS)を用いてテスト時の計算スケーラビリティを向上させることを検討しました。このアプローチでは、回答をより小さな部分に分割することで、モデルが解空間を体系的に探索できるようにします。これを促進するために、モデルに、探索に必要な特定の推論ステップに対応する複数のタグを生成するように促します。トレーニングでは、まず収集したプロンプトを用いて、事前学習済みの価値モデルに基づくMCTSで回答を見つけます。次に、得られた質問と回答のペアを用いて、アクターモデルと価値モデルの両方をトレーニングし、反復的にプロセスを改良していきます。

しかし、このアプローチは、トレーニングのスケールアップ時にいくつかの課題に直面します。まず、探索空間が比較的明確に定義されているチェスとは異なり、トークン生成では探索空間が指数関数的に大きくなります。この問題に対処するために、各ノードに最大拡張制限を設定しましたが、これによりモデルが局所最適解に陥る可能性があります。次に、価値モデルは探索プロセスの各ステップを導くため、生成の品質に直接影響を与えます。細粒度の価値モデルのトレーニングは本質的に困難であり、モデルを反復的に改善することが困難です。AlphaGoの成功の核心は、価値モデルをトレーニングしてパフォーマンスを徐々に向上させることに依存していましたが、トークン生成の複雑さのため、この原理を私たちの環境で再現することは困難です。

結論として、MCTSは事前学習済みの価値モデルと組み合わせることで推論時のパフォーマンスを向上させることができますが、自己探索を通じてモデルのパフォーマンスを反復的に向上させることは依然として大きな課題です。

さらに、推論能力を小規模な密モデルに蒸留する方法について検討します。DeepSeek-R1を教師モデルとして用い、80万個の学習サンプルを生成し、複数の小規模な密モデルをファインチューニングしました。結果は有望です。DeepSeek-R1-Distill-Qwen-1.5Bは、数学ベンチマークにおいてGPT-4oおよびClaude-3.5-Sonnetを上回り、AIMEで28.9%、MATHで83.9%の性能を達成しました。他の高密度モデルも同様に優れた結果を達成し、同じチェックポイントに基づく他の命令チューニングモデルを大幅に上回りました。

推論能力の蒸留を小規模な密モデルに適用する手法をさらに検討しました。DeepSeek-R1を教師モデルとして80万個の学習サンプルを生成し、複数の小規模な密モデルを微調整しました。その結果は有望で、DeepSeek-R1-Distill-Qwen-1.5Bは、数学ベンチマークにおいてGPT-4oおよびClaude-3.5-Sonnetを上回り、AIMEで28.9%、MATHで83.9%の性能を達成しました。他の密モデルも同様に優れた結果を達成し、同じチェックポイントに基づく他の命令チューニングモデルを大幅に上回りました。

今後、DeepSeek-R1については、以下の方向性で研究に投資していく予定です。